Американская компания OpenAI разработала новый тест для нейросетей SimpleQA. Он предназначен для измерения точности работы современных больших языковых моделей (LLM).

В результате исследования специалисты компании выяснили, что их самая современная нейросеть o1-preview, выпущенная в октябре 2024 года, дает правильные ответы только в 42,7% случаев. Результаты других моделей, например, Anthropic, оказались еще хуже, а одна из последних нейросетей Claude 3.5 Sonnet смогла ответить правильно только на 28,9% вопросов.

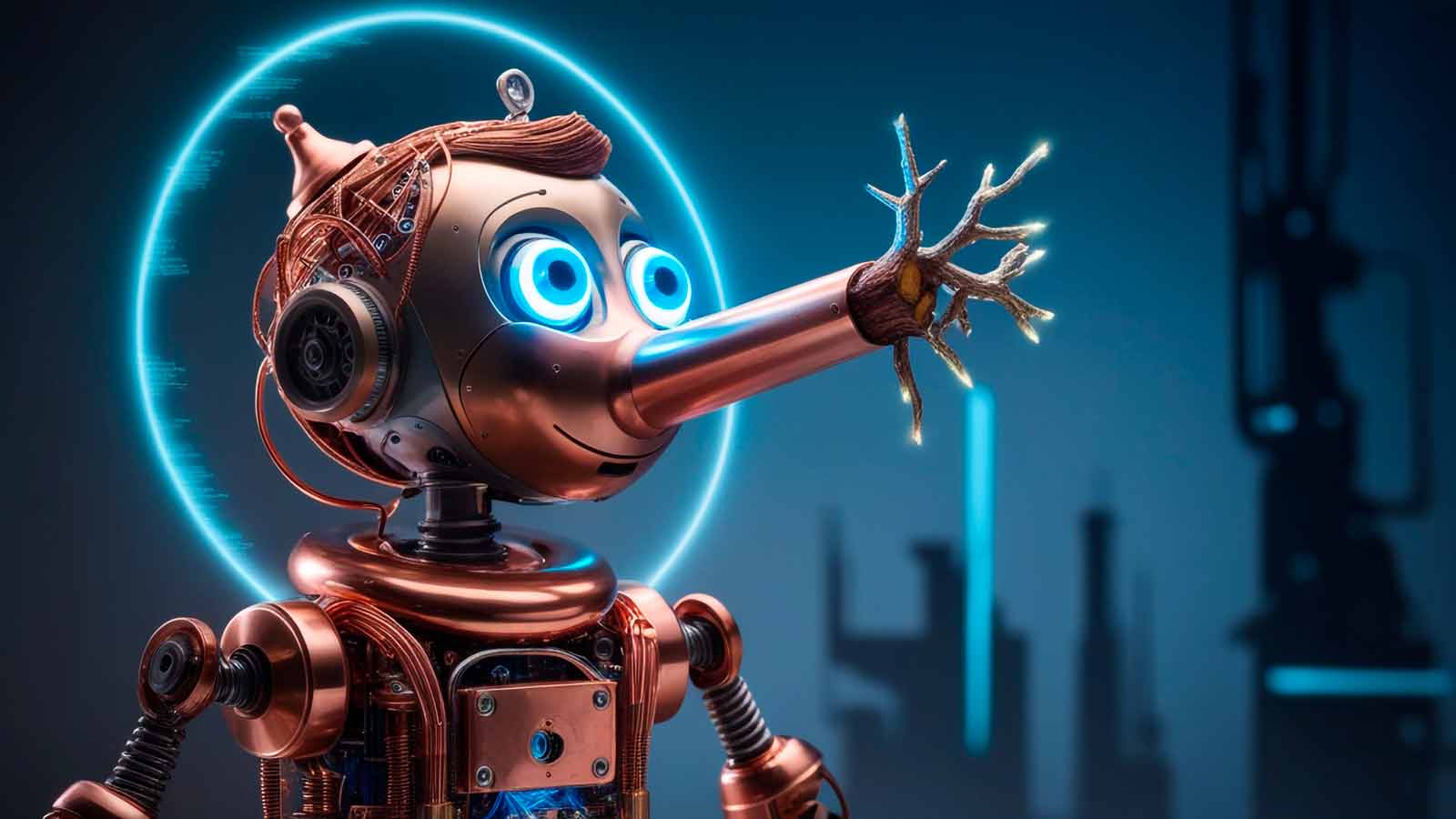

Таким образом, даже самые передовые LLM обманут пользователя с большей вероятностью, чем скажут правду. При этом OpenAI обнаружила, что нейросети в большинстве своем полностью уверены в собственной лжи.

Другими словами, даже лучшие из недавно анонсированных больших языковых моделей (LLM) с гораздо большей вероятностью дадут неверный ответ, чем правильный. Это тревожный сигнал, особенно с учетом того, что эта технология начинает проникать во многие аспекты нашей повседневной жизни.

Кстати, показавшая худшие результаты в тесте Claude 3.5 Sonnet гораздо более склонна признавать неуверенность и отказываться отвечать.

Исследование OpenAI показывает несовершенство современных больших языковых моделей, которые, тем не менее, широко используются практически во всех сферах нашей жизни. Результаты теста намекают на то, что нейросетям нельзя доверять полностью и следует тщательно проверять сгенерированные ими тексты.